Bei einer lauten Party, in der U-Bahn oder auch beim Skype-Anruf: Wir können uns viel besser auf das konzentrieren, was unser Gesprächspartner sagt, wenn wir der Person dabei auf die Lippen schauen. Doch was passiert beim Lippenlesen im Gehirn? Und wie testet man es?

Aus Bild wird Geräusch

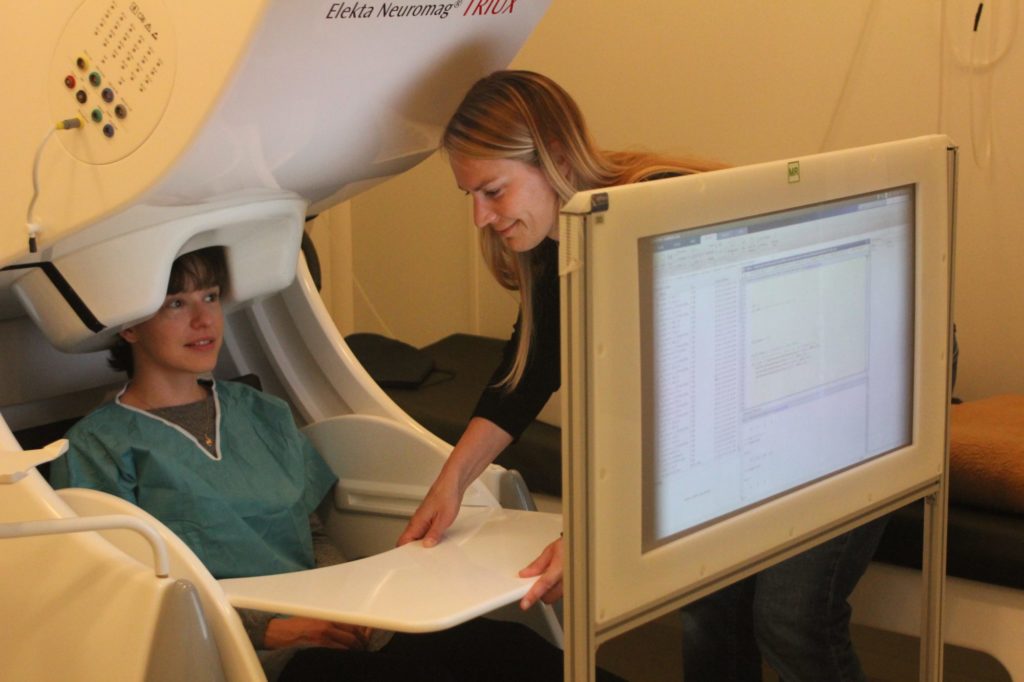

Dazu forscht Kristin Anne Hauswald zusammen mit einem Team der Uni Salzburg. Studien wie ihre helfen, besser zu verstehen, wie Lippenlesen funktioniert.

Die Idee dahinter ist, da wir ja beim Lippenlesen nicht hören können, dass visuelle Signale im Gehirn zu akustischen Signalen umgewandelt werden. Das ist gar nicht so einfach. Manche Menschen tun sich schwerer als andere beim Lippenlesen. Dass man es aber lernen kann, beweisen gehörlose Menschen immer wieder.

Videos ohne Ton verstehen

Um Lippenlesen besser zu verstehen, forscht Anne Hauswald danach, wie unser Gehirn visuelle in akustische Signale umwandelt. Eine Studie von ihr dazu ist erst vor Kurzem erschienen.

Dazu wurden 24 Versuchspersonen Videos ohne Ton und danach nur der Ton vorgespielt. „Wir haben die Information unimodal dargeboten”, sagt Hauswald. „Das heißt, wir haben entweder nur akustische oder visuelle Signale dargeboten.“

Wie misst man das Hören von Bildern?

Die Probanden mussten sich eine Weile auf die Signale, die sie bekamen, konzentrieren, während das Forschungsteam Hirnsignale mittels Magnetoenzephalographie (MEG) in sogenannten Zeitreihen aufzeichnete. Diese Zeitreihen wurden ebenfalls für die akustischen und die visuellen Signale aufgezeichnet.

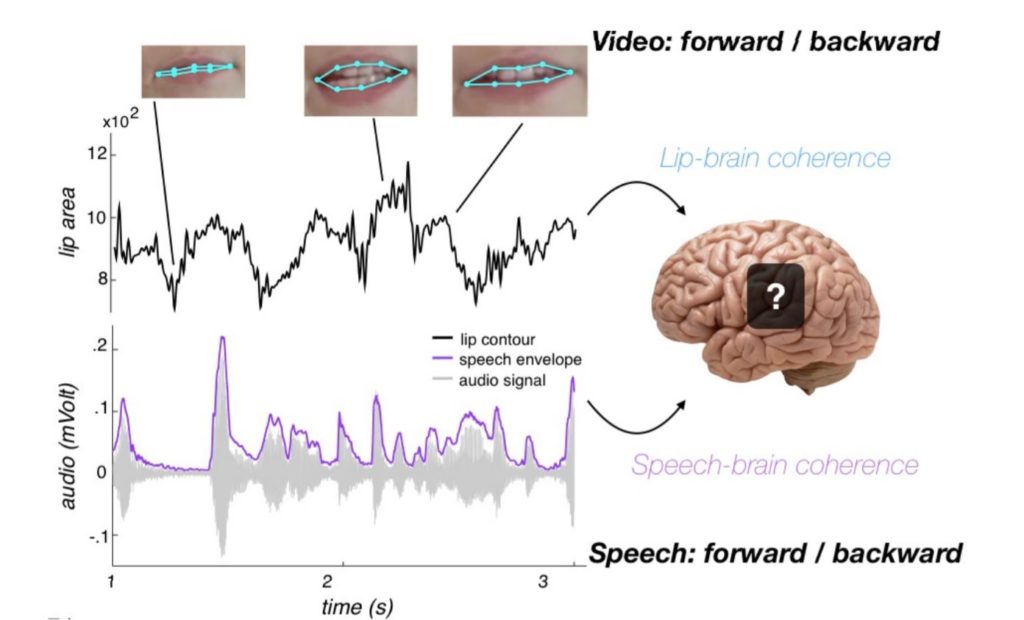

Später wurden die Zeitreihen des Gehirns und die der Signale miteinander verglichen.

„Was für uns am interessantesten war, ist, dass wir nicht die Zeitreihe der Lippenbewegungen, sondern die der dazugehörigen, aber nicht gehörten, akustischen Signale genommen haben”, erklärt Hauswald. „Dann haben wir quasi untersucht, inwieweit das Gehirn sich mit diesen nicht gehörten akustischen Signalen synchronisiert.”

Ergebnis intuitiv richtig

„Wir wollten Versuchsbedingungen ohne Aufgabenstellung haben, weil allein das Stellen einer Aufgabe das spontane Verarbeiten von Signalen verändert. Deswegen haben wir ein passives Design gewählt”, sagt Hauswald.

Zum Vergleich hat das Forschungsteam der Kontrollgruppe ebenfalls akustische und visuelle Signale vorgespielt, ihnen allerdings danach die Aufgabe gegeben, zum gehörten bzw. gesehenen Fragen zu beantworten.

Das Ergebnis war jenes, das man auch intuitiv annimmt. Gehörtes verstehen wir sehr gut, doch beim Lippenlesen versteht man in der Regel recht wenig. Wenn wir jemandem beim Reden auf den Mund sehen, verstehen, wir die Person auch besser. „Wenn die visuelle Information hilfreich ist, dann verbessern sie die auditorische Wahrnehmung”, so Hauswald.

Was dennoch spannend ist, ist, sich vorzustellen, wie das Gehirn eine rein visuelle Information im Gehirn in eine akustische umwandelt. Und auch, es bei der nächsten Party auszuprobieren.