Probieren geht über Studieren. Der Sinnspruch-Klassiker gilt auch für die Medikamenten- und Lebensmittelindustrie. Sie setzt auf immer neue Substanzen und gibt Unmengen für deren Erforschung aus. Die größte Herausforderung dabei: festzustellen, wie unbekannte Stoffe wirken. Welche Nebenwirkungen könnten auftreten? Bisher ein äußerst kostspieliges Unterfangen, das nur über praktische Versuchsreihen zu bewerkstelligen war. Die amerikanische Gesundheitsbehörde NIH wollte nun neue Wege gehen und veranstaltete dafür das Projekt „Tox21“. Ziel war es, das Probieren durch das Studieren durch Computern zu ersetzen. Sie sollten durch umfassende Berechnungen möglichst genaue Vorhersagen über die Giftigkeit von Substanzen treffen. Ein Team rund um Sepp Hochreiter und Projektkoordinator Günter Klambauer vom Institut für Bioinformatik der Universität Linz schaffte es, für 600 neue, bisher nicht getestete Substanzen, das verlässlichste Modell zu entwickeln.

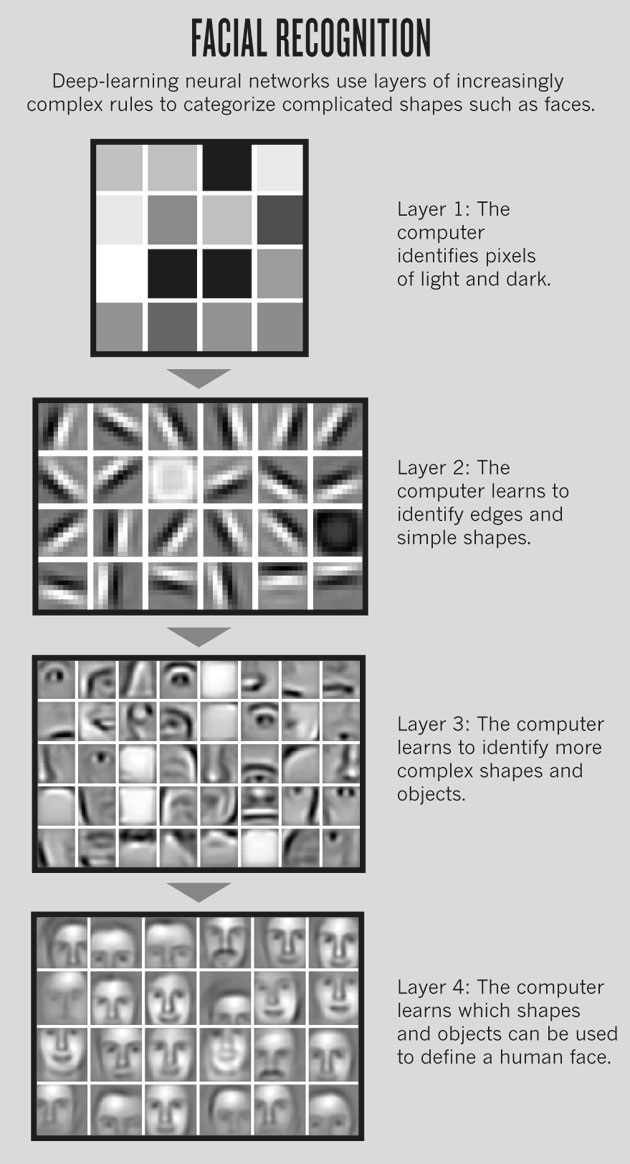

Die Linzer konnten die Giftigkeit einer Substanz mit einer Genauigkeit von rund 95 Prozent korrekt vorhersagen. Bei manchen Effekten lag die Fehlerrate sogar unter einem Prozent. Ein Ergebnis, das selbst die NIH überraschte. Dahinter steckt eine Technologie, die auch Googles Translator oder die Gesichtserkennung auf Facebook nutzen. Deep Learning nennt sich der Ansatz, der von Sepp Hochreiter in einer wegweisenden Diplomarbeit bereits 1990 skizziert wurde. „Untersuchungen zu dynamischen neuronalen Netzen“ nannte Hochreiter seine Arbeit, deren intellektuelles Versprechen erst durch die heutige Technik umgesetzt werden kann. „Es geht um mathematische Algorithmen, die Muster in Daten erkennen und wie Neutronen im menschlichen Gehirn funktionieren“, erklärt Günter Klambauer das Prinzip Deep Learning.

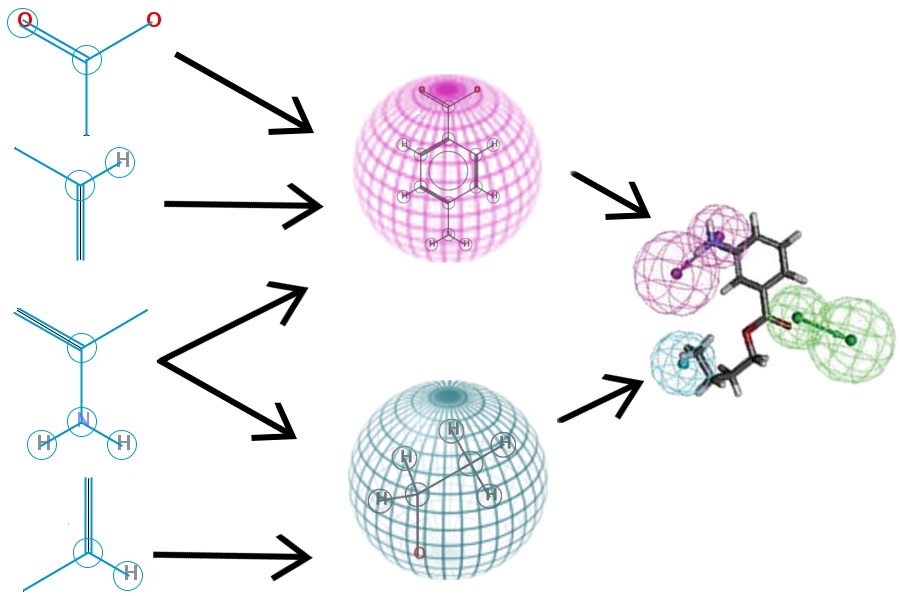

Für das Tox 21 Projekt entwickelten die Linzer Bioinformatiker die Methode DeepTox. Vereinfacht gesagt wurden Millionen chemischer Fingerabdrücke von rund 10.000 bekannten und 800 unbekannten Substanzen genommen. Im nächsten Schritt wurden sie in ihre kleinstmöglichen verwertbaren Eigenschaften zerlegt und auf 12.000 parallel geschalteten Prozessoren miteinander in Verbindung gesetzt, kombiniert und verglichen. Die erkannten Muster wurden dann für die Prognose herangezogen.

Deep Learning setzt schon heute vor allem im Bereich von Spracherkennung und der Klassifikation von Bildern neue Maßstäbe. Für Günter Klambauer ist es aber vor allem der Bereich der Medikamenten- und Nahrungsmittelsicherheit, der von den neuen Impulsen profitieren wird. „Wir können damit vorhersagen, ob ein Stoff giftig ist oder nicht, oder auch ob ein Stoff wie ein Hormon wirkt oder nicht.“ Aktuell werde die Methode etwa dafür eingesetzt, in der menschlichen DNA genetische Muster zu erkennen. Die mögliche Folge: eine computerbasierte Vorhersage, ob jemand krank wird oder nicht.

Deep Learning scheint das aktuell vielversprechendste Instrument zu sein, um im immer schneller wachsenden Datendschungel den Wald vor lauter Bäumen wieder zu entdecken. Doch auch die vernetzten Computer-Supergehirne können nicht alles. Gesichtserkennungsprogramme funktionieren teilweise mehr schlecht als recht – und nicht nur Apples Spracherkennung Siri stößt immer wieder an ihre Grenzen. Durch Deep Learning aber wurde die Fehlerquote bei der Spracherkennung von 24 auf 16 Prozent gesenkt. Warum tausende gekoppelte Rechner immer noch Fehler machen, liege schlicht an der Komplexität der Aufgabe, meint Günter Klambauer. „Bei der Erkennung von Handschriften macht auch der Mensch Fehler. Das können Maschinen mittlerweile gleich gut wie wir Menschen. Es bleibt aber schwierig, einem Computerprogramm beizubringen, auf einem Foto zwischen einem Hund und einer Katze zu unterscheiden.“ Trotzdem: schon wegen der Unmenge an Fotos und Daten gäbe es keine Alternativen zu Deep Learning Modellen, ist Klambauer überzeugt.

In Zukunft könnte das Programm, das die Tox21 Challenge souverän gewonnen hat, dazu beitragen, aktuell noch unbekannte Nebenwirkungen von Medikamenten herauszufinden. Manche Medikamente könnten als gesundheitsschädlich identifiziert und in Folge ganz vom Markt genommen werden. Für Klambauer geht es schlicht darum, die Gefahr durch ungetestete Substanzen für den Menschen zu reduzieren. „Es könnte sein, dass man künftig einen Barcode scannt und mit hoher Wahrscheinlichkeit vorhersagen kann, ob ein Stoff gefährlich ist oder nicht. Auch wenn der Stoff noch gar nicht gemessen wurde.“

Das erste Foto unseres Beitrags stammt von juliendn und zeigt Neuronen im menschlichen Gehirn. Es unterliegt der Lizenz CC BY-NC-SA 2.0